Einleitung §

Lange Zeit galten menschliche Individuen und Gesellschaften als die einzigen intelligenten Entscheidungsträger. Durch die Fortschritte in der Informatik, insbesondere in den Bereichen Künstliche Intelligenz und Machine Learning, entstanden autonom agierende Maschinen, die dem Menschen diese Position zunehmend streitig machen. Während diese autonomen Systeme bisher nur in abgegrenzten Gebieten eingesetzt wurden, wird erwartet, dass sie in Zukunft sämtliche Bereiche des gesellschaftlichen Lebens durchdringen werden. Die Bandbreite reicht dabei von Pflege- bis hin zu militärischen Robotern. Die Front dieser Generation von neuen, intelligenten Systemen bilden derzeit führerlose Autos, die bereits in der Praxis getestet werden.

Das Aufkommen dieser neuen Klasse von Entscheidungsträgern wirft ein anderes Licht auf einige ältere ethische Fragen, wie z.B. das Trolley-Problem. Die Moralphilosophie behandelt solche und ähnliche Dilemmata bereits seit langer Zeit, jedoch vor allem unter der Annahme, dass es sich bei den moralischen Agenten um Menschen handelt. Es hat sich gezeigt, dass sich die populären Ansätze wie der Konsequentialismus und die Deontologische Ethik relativ einfach auf nicht-menschliche Agenten übertragen lassen. In der praktischen Anwendung stellt sich jedoch die Frage, wie Ethisches Verhalten in nicht-menschlichen Agenten implementiert werden kann.1

Im Folgenden sollen bekannte Implementierungsstrategien für moralisches Verhalten am Beispiel selbstfahrender Autos untersucht werden. Dazu wird zunächst erläutert, warum ungeschriebene ethische Regeln für künstliche Systeme von Bedeutung sind und wie sie sich zu expliziten Regeln (z.B. der Straßenverkehrsordnung) verhalten. Anschließend werden moralphilosophische Theorien vorgestellt, welche die Grundlage der meisten Implementierungen darstellen. Danach folgen einige ausgewählte Implementierungsstrategien, die zuletzt diskutiert werden.

Abgrenzung §

Um den Rahmen der Arbeit einzugrenzen, werden im Folgenden einige Aspekte der Maschinenethik aufgezeigt, die nicht weiter betrachtet werden. So soll nicht erörtert werden, ob Maschinen aus philosophischer Perspektive die grundsätzliche Befähigung zu moralischem Verhalten besitzen. Aus Sicht der Kantschen Ethik ist ein Agent nur dann im Stande moralisch zu handeln, wenn er (1) alternative Entscheidungen treffen könnte und (2) “bewusst” die moralisch richtige Entscheidung trifft. Beide Kriterien werden durch Roboter nur bedingt erfüllt, da (insbesondere) bei Maschinen streitbar ist, ob und zu welchem Grad sie über freien Willen verfügen, der ihnen das tatsächliche Entscheiden ermöglichen würde. Andererseits ist ungeklärt, ob und wie Maschinen in der Lage sein können, sich einer solchen Entscheidung bewusst zu sein. Es soll also weder über freien Willen noch über Bewusstsein diskutiert werden.

Moralische Regeln §

Es wird im Folgenden für die Notwendigkeit von ethisch handelnden Maschinen argumentiert. Eine solche Argumentation kann allerdings nicht auf der Basis einer moralischen Bewertung erfolgen, da dies nur unter der jeweils angewandten moralischen Perspektive gültig wäre.2 Um einen Zirkelschluss zu vermeiden, erfolgt eine Betrachtung aus marktwirtschaftlicher Sicht.3

Nach Maurer et al.2 werden autonome Fahrzeuge bzw. die sie steuernden Algorithmen nicht anhand von Statistiken oder durch Tests bewertet, sondern durch die ethischen und moralischen Standards der Gesellschaft. So wäre ein amokfahrendes Auto für die Hersteller ein PR-Desaster, wohingegen Autos mit sozial vorbildlichem Verhalten die soziale Akzeptanz (und somit ggf. auch die Absatzzahlen) erhöhen können. Wenn ein Auto also einen Unfall verursacht, ist es notwendig, dass es eine unter diesen Umständen von der Gesellschaft als moralisch vertretbar wahrgenommene Entscheidung getroffen hat. Dabei wird es nicht ausreichen, sich lediglich an die expliziten juristischen Gesetze zu halten und dabei die ungeschriebenen gesellschaftlichen Normen zu ignorieren. Dies würde zwar eine Verurteilung vor Gericht verhindern, nicht jedoch eine Verurteilung durch die Gesellschaft.

Unabhängig davon, ob Maschinen schuldfähig sein können, wird die Schuld für als unmoralisch wahrgenommene Entscheidung den Herstellern gegeben werden, denn ein Auto — das in absehbarer Zeit nicht als Entität mit freiem Willen gesehen wird — kann aus Sicht der Gesellschaft schwerlich selbst für etwaiges Fehlverhalten verantwortlich gemacht werden. Aus diesen Gründen ist es also aus marktwirtschaftlicher Sicht sinnvoll, Verhalten zu implementieren, das zumindest nach außen moralisch wirkt.

Verkehrsregeln §

Wie bereits festgestellt, ist es für die Autohersteller von Vorteil, moralische Überlegungen in die Entscheidungslogik ihrer autonomen Fahrzeuge zu integrieren. Noch nicht geklärt ist, wie mit Straßenverkehrsregeln umgegangen werden soll. Maurer et al.2 behaupten, dass es sich bei Straßenverkehrsregeln in der Praxis nicht um tatsächliche Regeln handelt, die unbedingt eingehalten werden müssen, sondern eher um Richtlinien, die mit anderen Einflussfaktoren wie der Verkehrssicherheit, dem Verkehrsfluss oder allgemein der Zweckdienlichkeit abgewogen werden müssen. So hatte beispielsweise ein selbstfahrendes Auto von Google in Praxistests Schwierigkeiten an vierarmigen Kreuzungen, weil die anderen, menschlichen Autofahrer vor dem Weiterfahren nicht lange genug hielten, während das Google-Auto auf Rücksicht programmiert wurde und die anderen Fahrer passieren ließ, ohne selbst jemals loszufahren. Als Konsequenz wurde es den Autos erlaubt, die Verkehrsregeln zu brechen, wenn ihr Nutzer es ihnen befahl.

Allgemein lässt sich festhalten, dass es für die Autohersteller unvorteilhaft wäre, wenn die Autos durch das strikte Einhalten der Verkehrsregeln z.B. den Verkehrsfluss aufhielten, weil dies die gesellschaftliche Akzeptanz verringern könnte. Eine praxistaugliche Implementierung sollte daher die Interessen der unterschiedlichen Verkehrsteilnehmer gegeneinander abwiegen, anstatt Verkehrsregeln als in jedem Fall einzuhaltende Regeln anzusehen.

Moralphilosophische Theorien §

Dieser Abschnitt stellt einige moralphilosophische Theorien vor, die sich eignen könnten, um eine berechenbare mathematische Beschreibung von Moral zu erzeugen. Die hier gewählte Gliederung orientiert sich an Allen et al.4, wobei anzumerken ist, dass sich eine strikte Einteilung aufgrund unscharfer Grenzen nur schwer erreichen lässt.

Konsequentialismus §

Der Konsequentialismus beschreibt die Ansicht, dass die normative Einordnung einer Handlung nur von ihren Konsequenzen abhängt. Zu den konsequentialistischen Ethiken gehören beispielsweise der Utilitarismus und der ethische Egoismus.

Utilitarismus §

Der Utilitarismus befindet diejenige Entscheidung für gut, deren Konsequenzen den größtmöglichen aggregierten Gesamtnutzen für alle Individuen bedeuten. Man kann den Utilitarismus dementsprechend als Optimierungsproblem auffassen.

Ethischer Egoismus §

Die Theorie des ethischen Egoismus betrachtet diejenigen Handlungen als gut, die dem handelnden Individuum maximal nützen. Sie kann wie der Utilitarismus auch als Optimierungsproblem aufgefasst werden, berücksichtigt die Interessen anderer aber nur insoweit, wie dies den eigenen Interessen dient.

Deontologische Ethik §

In der deontologischen Ethik (oder Pflichtethik) wird die normative Einordnung einer Handlung nicht (nur) aufgrund ihrer Konsequenzen vorgenommen. Zusätzlich können bestimmte Handlungen als intrinsisch gut oder schlecht gelten (z.B. lügen oder töten), wobei sich der Grad des Absolutheitsanspruchs zwischen verschiedenen Strömungen unterscheidet. Es kann zudem zu Konflikten zwischen verschiedenen Regeln kommen, wenn jemand in eine Situation gerät, in der er entweder töten oder aber lügen muss. Auch der Umgang mit derartigen Konflikten ist unterschiedlich.

Kategorischer Imperativ §

Der kategorische Imperativ Kants lässt sich als eine Pflicht im Sinne der deontologischen Ethik verstehen. Er lautet:

“Handle nur nach derjenigen Maxime, durch die du zugleich wollen kannst, dass sie ein allgemeines Gesetz werde.”

Eine ausführlichere Beschreibung kann der umfangreichen Literatur zu diesem Thema entnommen werden.

Asimovsche Ethik §

Im Gegensatz zu anderen Theorien, die zunächst für menschliche Agenten gedacht waren, wurde die Asimovsche Ethik explizit als Regelsystem für Maschinen formuliert und betont dementsprechend auch den Unterschied, wobei den Menschen Vorrang eingeräumt wird.5 Die Regeln lauten:

- Ein Roboter darf kein menschliches Wesen (wissentlich) verletzen oder durch Untätigkeit (wissentlich) zulassen, dass einem menschlichen Wesen Schaden zugefügt wird.

- Ein Roboter muss den ihm von einem Menschen gegebenen Befehlen gehorchen — es sei denn, ein solcher Befehl würde mit Regel eins kollidieren.

- Ein Roboter muss seine Existenz beschützen, solange dieser Schutz nicht mit Regel eins oder zwei kollidiert.

Asimov begegnet der Möglichkeit von Konflikten der Regeln durch eine strikte Priorisierung. Für den Straßenverkehr sind diese Gesetze vermutlich nicht ausreichend, dennoch haben sie einen großen Einfluss auf das Gebiet der Maschinenethik und es existieren mehrere Implementierungen.67 Daher sollen die Asimovschen Robotergesetze als Prototyp einer strikt hierarchischen deontologischen Ethik erwähnt werden.

Tugendethik §

Die Tugendethik bewertet diejenigen Handlungen als gut, welche tugendhaft sind oder zumindest aus gutem Willen erfolgen. Bei einer Literaturrecherche ließen sich hierzu keine konkreten Implementierungsversuche finden. Laut Allen et al.8 lassen sich Tugendethiken auf Deontologische Ethiken zurückführen, indem Tugenden als Pflichten formuliert werden. Abstrakte Tugenden lassen sich allerdings nur schwer mathematisch erfassen. Die Tugendethik wird daher im Folgenden nicht weiter betrachtet.

Implementierungsstrategien §

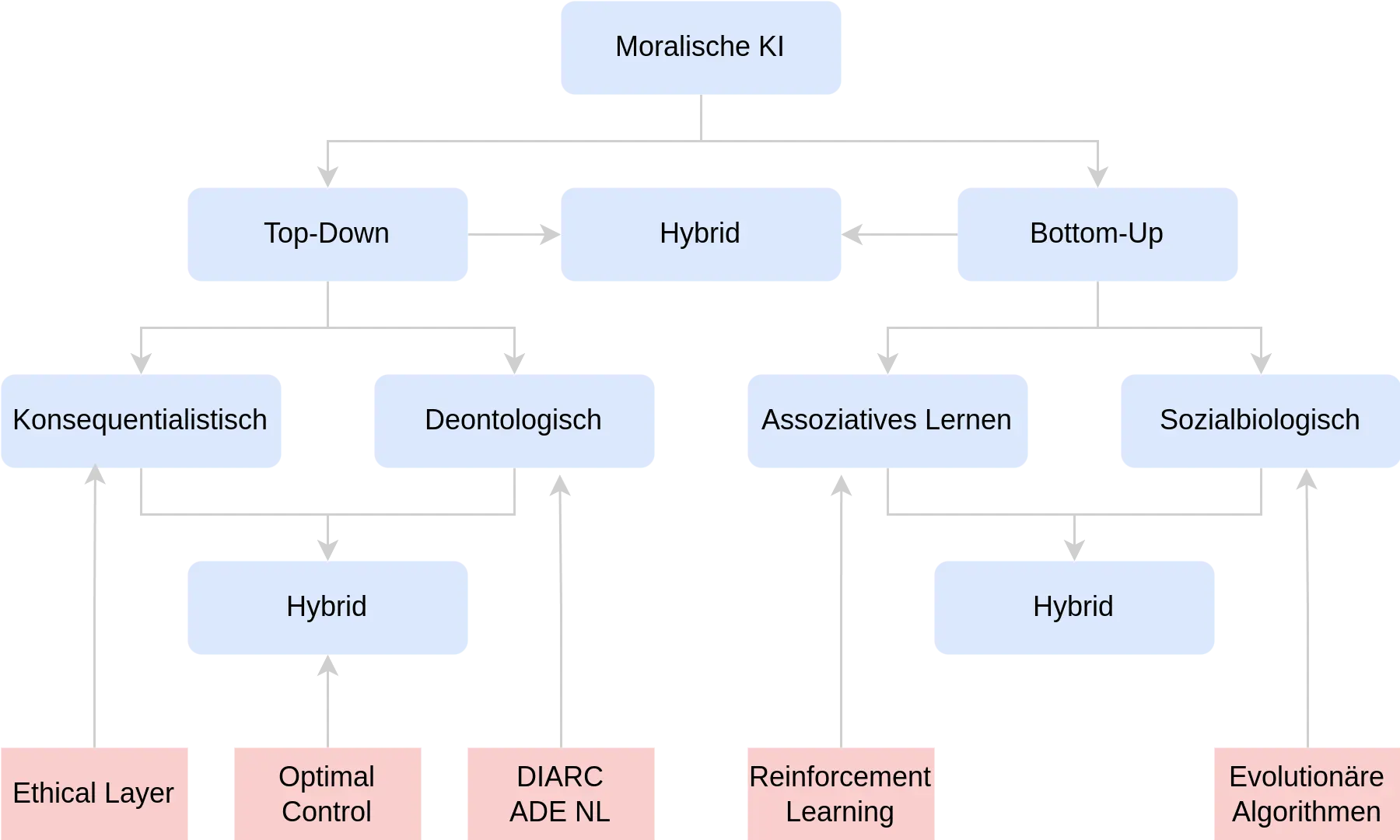

Verschiedene Quellen schlagen unterschiedliche Gliederungen für Implementierungsansätze vor.98 In Anlehnung an Allen et al.4 lassen sich einige Strategien wie folgt klassifizieren, wobei die Grenzen fließend sein können.

Grobe Einteilung der Strategien für die Implementierung moralischer AI (Blau). Bereits existierende Implementierungen sind Rot dargestellt. Zu Bottom-Up-Hybrid-Verfahren konnte keine Literatur gefunden werden. Es existieren keine bekannten Top-Down-Bottom-Up-Hybrid-Implementierungen.

Top-Down §

Bei Top-Down-Ansätzen versucht man, ein System zu entwerfen, das eine vorgegebene Aufgabe löst. Übertragen auf moralische KI bedeutet dies, eine konkrete Moralphilosophie algorithmisch abzubilden. Während sich dieses Vorgehen für “allgemeine” künstliche Intelligenz als zu unflexibel erwiesen hat, kann es in bestimmten Spezialbereichen weiterhin nützlich sein.4

Konsequentialismus §

Ein Beispiel für eine konsequentialistische Implementierung liefert der “Ethical Layer.”7 Dort führt ein moralischer Agent interne Simulationen durch, um die Konsequenzen seiner Handlungen abzuschätzen, die dann ethisch bewertet werden. Der Ansatz ist von der Theorie der simulierenden Kognition inspiriert.10 Experimente zeigen, dass ein so programmierter Agent die Asimovschen Gesetze befolgen kann, indem er in allen Szenarien Handlungen vermeidet, die gegen diese Gesetze verstoßen würden.

Vereinfachte Darstellung der Ethical-Layer-Architektur. Die Steuerungseinheit des Roboters ermittelt aus den aktuellen Zielen mögliche Handlungen und schickt diese an den Ethical-Layer. In dessen Simulations-Modul werden die erwarteten Zustände der Welt für die jeweiligen Handlungen berechnet. Die Ergebnisse dieser Simulationen werden dann durch ein Evaluations-Modul nach Ethischen Maßstäben bewertet und abschließend an die Steuerungseinheit zurückgeschickt.

Deontologische Ethik §

Eine Implementierung deontologischer Ethik beschreibt Briggs und Scheutz.11 Ein Agent arbeitet hier auf einer widerspruchsfreien Menge von Regeln $\varphi$. Erhält er einen Auftrag $\alpha$, prüft er zunächst, ob er eine Pflicht $\mathrm{obl}$ zur Erfüllung hat und ob dies seinen aktuellen Zielen widerspricht. Falls nicht, fügt er sich das Erfüllen des Auftrags als neues Ziel hinzu. Formal kann dies wie folgt ausgedrückt werden: $$ \mathrm{obl}(\alpha, \varphi) \wedge \neg \mathrm{per}(\alpha, \neg \varphi)\ \rightarrow \mathrm{goal}(\alpha, \varphi) $$

Hybrid (Top-Down) §

Manche Autoren vertreten die Ansicht, dass eine einzelne Ethik nicht genügt, um Moral in autonomen Fahrzeugen vollständig zu implementieren.212 Daher existieren Modelle, die deontologische und konsequentialistische Elemente zusammenführen. Maurer et al.2 beschreiben etwa einen Ansatz mit einer Mischung aus Kostenfunktion (Utility) und unverletzbaren Regeln. Die Kostenfunktion berücksichtigt gewichtete Teilziele (z.B. Verkehrsregeln, Transportbedürfnisse des Nutzers). Für jede potenzielle Trajektorie des Fahrzeugs wird die Kostenfunktion berechnet. Anschließend wird versucht, die Kosten zu minimieren. Die strikten Regeln dagegen dürfen in keinem Fall verletzt werden. So soll etwa verhindert werden, dass das Fahrzeug einen Fußgänger überfährt, nur weil scharfes Bremsen für die Insassen unangenehm wäre. Dilemma-Situationen werden durch Prioritäten für die Regeln aufgelöst. Mathematisch interpretiert man dies als eine Optimierung der Kostenfunktion unter bestimmten Constraints.

Bottom-Up §

Bottom-Up-Ansätze verzichten darauf, die Moralphilosophie vorzuschreiben. Stattdessen wird das System “von unten” her aufgebaut, indem es schrittweise lernt (oder im evolutiven Sinne “heranwächst”), wie es sich verhalten sollte, ohne dass explizit eine bestimmte Moraltheorie implementiert wird.

Assoziatives Lernen §

Beim assoziativen Lernen erwirbt ein Agent das erwartete moralische Verhalten anhand von Feedback. Abel et al.9 beschreiben ein Beispiel mit Reinforcement Learning in Form eines Markow-Entscheidungsproblems. Dieses wird definiert durch

- Zustände $s \in S$,

- Aktionen $a \in A$,

- eine Belohnungsfunktion $R(s,a)$ und

- eine Wahrscheinlichkeitsverteilung $T(s,a,s’)$ für Zustandsübergänge von $s$ nach $s’$, gegeben Aktion $a$.

Der Agent wählt in jedem Zustand $s$ eine Aktion $a$, erhält eine Belohnung und wechselt gemäß $T$ in einen Folgezustand $s’$. Das Ziel ist es, über die Zeit möglichst viel Belohnung anzusammeln. Experimentell ließ sich zeigen, dass der Agent hierbei bestimmte Dilemmata wie das “Cake or Death” Problem13 auflösen kann.

Soziobiologisch §

Soziobiologische Ansätze versuchen, durch die Simulation einer biologischen Evolution moralische Agenten hervorzubringen. Viele existierende Arbeiten konzentrieren sich dabei auf Szenarien, in denen Individuen in direkter Konkurrenz stehen.14 Hier kommt ihnen Kooperationsverhalten zugute, wodurch sich ein evolutiver Vorteil ergibt. Dieser “eigennützige Ursprung der Moral” kann mancher Auffassung nach auch beim Menschen beobachtet werden.4 Da auf diesem Weg letztlich das eigene Überleben im Verbund gefördert wird, lässt sich dies als eine Form des ethischen Egoismus werten. Für den Einsatz in autonomen Fahrzeugen ist bislang keine derartige Lösung bekannt, was wohl an der hohen Komplexität dieses Anwendungsfalls liegt.

Hybrid (Bottom-Up) §

Es ist auch denkbar, Bottom-Up- und Top-Down-Ansätze zu kombinieren.14 Beispielsweise könnte man bestimmte Grundregeln fest einprogrammieren und unzugänglich machen, während das System weniger starre Normen oder Prioritäten durch Erfahrung lernt. Ein Vergleich zum Menschen wird oft angeführt: Genetische Anlagen und gesellschaftliche Prägung schaffen die Grundlage, auf der sich individuelle moralische Vorstellungen ausbilden. Eine andere Möglichkeit wäre, dass ein System Bottom-Up lernt, die Folgen seiner Handlungen einzuschätzen, bevor es anschließend Top-Down eine ethische Entscheidung fällt.

Hybrid §

Sehr selten werden beide Prinzipien miteinander kombiniert, etwa indem man Top-Down-Module mit einem Bottom-Up-Mechanismus zur automatischen Bestimmung von Parametern (z.B. Gewichte in Kostenfunktionen) verbindet. In anderen Bereichen werden solche Methoden durchaus genutzt (etwa Evolutionäre Algorithmen zur Hyperparameter-Optimierung im Deep Learning).15 Für das autonome Fahren bleibt dies weitgehend unerforscht.

Diskussion §

Top-Down §

Konsequentialistische Ansätze stoßen in der praktischen Umsetzung an Grenzen, weil sie einerseits nie vollständige Informationen über die Welt haben können und andererseits in der Theorie unendlich weit in die Zukunft schauen müssten.8 Dennoch wird dieses Problem in der Praxis meist dadurch entschärft, dass nur bis zu einem sinnvollen Zeithorizont oder nur über eine begrenzte Zahl an Handlungsalternativen simuliert wird. Der Ethical Layer7 zeigt trotz dieser Grenzen keine offensichtlichen Nachteile, wenngleich es in Echtzeit-Szenarien (z.B. drohenden Unfallsituationen) komplex werden kann, schnell genug alle potenziellen Handlungen zu simulieren.

Deontologische Systeme sind in ihrer Logik oft eindeutig interpretierbar und erlauben Beweise über bestimmte Zusicherungen (z.B. dass nie eine Regel verletzt wird). Dies ist bei sicherheitskritischen Anwendungen ein wichtiger Vorteil. Allerdings erweisen sie sich als unflexibel, da sie eventuell nicht zulassen, im Bedarfsfall Verkehrsregeln zu verletzen, wenn dies ein höheres Gut schützen würde. Außerdem eignen sie sich schlecht für Dilemmata, in denen alle verfügbaren Handlungsoptionen “schlecht” sind. Manche Philosophen, wie Kant, versuchen durch eine einzige, sehr komplexe Regel (den Kategorischen Imperativ) verschiedene Fälle abzudecken, was wiederum praktisch schwer umsetzbar ist.8

Hybride Top-Down-Systeme versuchen, deontologische und konsequentialistische Ideen zu verbinden. Sie können bestimmte unverletzliche Regeln vorschreiben und für andere Aspekte eine Kostenfunktion minimieren. Maurer et al.2 haben dies für autonome Fahrzeuge diskutiert. Das Problem verschiebt sich allerdings oft auf die Auswahl und Gewichtung der Regeln und Kostenfunktionen. Sofern diese nicht “richtig” gewählt sind, wird das Ergebnis in den Augen der Gesellschaft nicht als moralisch akzeptabel erscheinen.

Bottom-Up §

Der Vorteil von Bottom-Up-Ansätzen liegt darin, dass sie keine bestimmte Moraltheorie “hart kodieren.” Sie können also selbstständig lernen, wie sie sich verhalten sollten, auch wenn die Gesellschaft widersprüchliche Vorstellungen hat. Gleichzeitig ist ein Nachteil, dass Entscheidungsfindungen solcher Systeme meist undurchsichtig sind (z.B. bei neuronalen Netzen). Für sicherheitskritische Anwendungen möchte man jedoch nachvollziehbare Systeme. Hier bleibt also abzuwarten, wie weit Forschung zu Erklärbarkeit und Transparenz kommt.16

Fazit §

Diese Arbeit hat verschiedene Strategien zur Implementierung von Moral in autonomen Systemen vorgestellt, speziell am Beispiel selbstfahrender Autos. Es wurde erläutert, warum ungeschriebene moralische Regeln — neben den geschriebenen Verkehrsgesetzen — von Bedeutung sind. Ferner wurden verschiedene Moralphilosophien skizziert, die als Basis für Implementierungen dienen können, insbesondere der Konsequentialismus und die Deontologische Ethik. Die vorgestellten Strategien wurden in Top-Down-, Bottom-Up- und Hybrid-Ansätze unterteilt. Die Grenzen sind jedoch fließend. Nach einer Diskussion der Stärken und Schwächen erscheint vor allem der Ethical Layer aussichtsreich, da er eine generische, konsequentialistisch inspirierte Architektur zur moralischen Entscheidungsfindung liefert und zugleich an spezifische Anforderungen angepasst werden kann. Zudem lassen sich Hybrid-Varianten konstruieren, bei denen unterschiedliche moralische Theorien oder Lernverfahren je nach Bedarf kombiniert werden.

Vicky Charisi, Louise Dennis, Michael Fisher, Robert Lieck, Andreas Matthias, Marija Slavkovik, Janina Sombetzki, Alan F. T. Winfield, and Roman Yampolskiy. Towards moral autonomous systems. arXiv preprint arXiv:1703.04741, 2017. ↩︎ ↩︎

Markus Maurer, J. Christian Gerdes, Barbara Lenz, and Hermann Winner. Autonomes Fahren: Technische, rechtliche und gesellschaftliche Aspekte. Springer-Verlag, 2015. ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

Ebd. (vgl. dortige Argumentation) ↩︎

Colin Allen, Iva Smit, and Wendell Wallach. Artificial morality: Top-down, bottom-up, and hybrid approaches. Ethics and Information Technology 7(3):149–155, 2005. ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

Susan Leigh Anderson. Asimov’s “Three Laws of Robotics” and machine metaethics. AI & Society, 22(4):477–493, 2008. ↩︎

Mateo Alvarez, Øyvind Berge, Audun Berget, Eirin Bjørknes, Dag V. K. Johnsen, Fredrik Madsen, and Marija Slavkovik. Implementing Asimov’s First Law of Robotics. 30th Norsk Informatikkonferanse, NIK, pages 27–29, 2017. ↩︎

Dieter Vanderelst and Alan Winfield. An architecture for ethical robots inspired by the simulation theory of cognition. Cognitive Systems Research, 48:56–66, 2018. ↩︎ ↩︎ ↩︎

Colin Allen, Gary Varner, and Jason Zinser. Prolegomena to any future artificial moral agent. Journal of Experimental & Theoretical Artificial Intelligence, 12(3):251–261, 2000. ↩︎ ↩︎ ↩︎ ↩︎

David Abel, James MacGlashan, and Michael L. Littman. Reinforcement learning as a framework for ethical decision making. In Workshops at the Thirtieth AAAI Conference on Artificial Intelligence, 2016. ↩︎ ↩︎

Simulation theory of cognition (allgemeines Konzept in der Kognitionswissenschaft). ↩︎

Gordon Michael Briggs and Matthias Scheutz. “Sorry, I can’t do that”: Developing mechanisms to appropriately reject directives in human-robot interactions. In 2015 AAAI fall symposium series, 2015. ↩︎

Noah J. Goodall. Machine ethics and automated vehicles. In Road Vehicle Automation, pages 93–102. Springer, 2014. ↩︎

Stuart Armstrong. Motivated value selection for artificial agents. In Workshops at the Twenty-Ninth AAAI Conference on Artificial Intelligence, 2015. ↩︎

Robert Axelrod and William D. Hamilton. The evolution of cooperation. Science, 211(4489):1390–1396, 1981. ↩︎

Steven R. Young, Derek C. Rose, Thomas P. Karnowski, Seung-Hwan Lim, and Robert M. Patton. Optimizing deep learning hyper-parameters through an evolutionary algorithm. In Proceedings of the Workshop on Machine Learning in High-Performance Computing Environments, page 4. ACM, 2015. ↩︎

Kevin Baum, Holger Hermanns, and Timo Speith. From machine ethics to machine explainability and back. In ISAIM, 2018. ↩︎